Jak naprawić index bloat i błędy stron w Google

Ta strona jest praktycznym, komercyjnym przewodnikiem dla firm, które chcą skutecznie kontrolować index bloat, poprawić seo, pozycjonowanie stron i zwiększyć widoczność swoich stron internetowych w wynikach wyszukiwania przez google oraz inne wyszukiwarki.

Dzięki temu poradnikowi zrozumiesz, czym jest index bloat w kontekście zarządzania indeksu, crawl budget i technicznych działań, poznasz najczęstsze problemy z indeksacją, a następnie przełożysz tę wiedzę na konkretne kroki, które można szybko wdrożyć w twojej witrynie bez zbędnych komplikacji.

Co to jest index bloat w technicznym seo i czym jest dla dużych stron internetowych?

Index bloat w praktyce odnosi się do witryn internetowych z wysoką liczbą stron, które są 'nadęte' stronami o niskiej wartości biznesowej i treściowej; te dodatkowe elementy i adresów url nie wnoszą jakości dla użytkowników ani dla google. Te strony są następnie indeksowane przez wyszukiwarki, negatywnie wpływając na wydajność Twojej witryny, stan indeksu oraz performance całej domeny w wyszukiwarce.

W uproszczeniu index bloat oznacza, że strona jest zaindeksowana w sposób nadmierna, google indeksuje zbyt wiele podstron technicznych, archiwalnych lub testowych i roboty wyszukiwarek marnują crawl budget na treści o niskiej wartości, zamiast koncentrować się na kluczowe strony ofertowe, kategorie, content marketing czy blog.

Dlaczego index bloat jest zły dla SEO i pozycjonowanie stron?

Głównym problemem jest to, że index bloat oznacza, że strony o niskiej wartości przeważają nad stronami o wysokiej wartości, sprzedaży lub leadów, więc google i inni widzą w indeksie zbyt wiele zbędnych adresów url. To oznacza, że wyszukiwarki będą postrzegać Twoją witrynę jako o niskiej wartości i niższej jakości, co może obniżać pozycje w wynikach wyszukiwania oraz ograniczać ruchu organicznego. Nawet jeśli wkładasz dobry wysiłek w swoje strony o wysokiej wartości, zostanie to przeważone przez te strony o niskiej wartości i błędne sygnały wysyłane robotom.

Twoim głównym celem z SEO i optymalizacja technicznych elementów jest, aby crawler wyszukiwarki mógł:

- Znaleźć treść, którą chcesz, aby znalazł, czyli strony ofertowe, kategorie, artykuły eksperckie i inne wartościowe treści.

- Rankingować ją dobrze w wynikach wyszukiwania i w wyszukiwarce google, tak aby zwiększyć widoczności oraz liczbę konwersji.

- Ignorować treść, którą nie chcesz indeksować, taką jak testowe strony, wyniki wewnętrznego wyszukiwania, polityka prywatności, strona z regulaminem lub koszyk.

Gdy witryna ma wysoką liczbę stron, ale wiele z tych stron jest niskiej jakości, marnuje to Twój cenny budżet crawl i crawl budget, utrudnia audyt seo oraz utrudnia analizę w google search console czy google analytics. To, oczywiście, może następnie pogorszyć ogólny ranking Twojej witryny w wyszukiwarkach, przez google może być oceniana jako mniej wartościowa i wolniejsza. Z tego powodu jest to ważny element, na który należy regularnie zwracać uwagę podczas przeglądu technicznych problemów i optymalizacja struktury.

Jakie są przyczyny index bloat i najczęstsze problemy z indeksacją?

Jednymi z głównych ofiar index bloat są witryny e-commerce i sklepów online, ponieważ zwykle mają wiele stron produktów oraz dynamiczne parametry filtrów. Nawet po tym, jak produkty nie są już dostępne, URL i strona mogą nadal być indeksowane przez google, co generuje błędy indeksowania oraz problemy z indeksacją. Wyszukiwania produktów i funkcje filtrowania mogą również powodować setki lub tysiące 'nadętych' stron generowane automatycznie. Istnieje również wiele innych przyczyn index bloat, takich jak:

- Wewnętrzne duplikaty linków i paginacja, źle zaprojektowane linkowanie wewnętrznego, zduplikowane kategorie oraz archiwa.

- Śledzące URL, które zawierają ciąg zapytania na końcu adresów url, parametry kampanii ads lub wewnętrzne tagi śledzące.

- Automatycznie generowane profile użytkowników, treści systemowe oraz inne strony, które mogą zostać przypadkowo zaindeksowana.

- Rozwój strony, migracja i przebudowy często pozostawiają bezużyteczne strony testowe, stare wersji na subdomenach lub domeny tymczasowe.

- Witryny blogowe często generują strony archiwalne, takie jak miesięczne archiwa, tagi blogów, tagi kategorii i tak dalej, oraz dodatkowe paginacje artykuły. Z czasem budują się one w znaczącą treść nadętą i index bloat.

- Źle uporządkowana mapa witryny XML i wewnętrzne linkowanie w menu. Gdy mapa witryny i mapy site nie jest odpowiednio przemyślana, może prowadzić do marnowania budżetu crawl oraz problemów indeksowania stron. Po tym, jak crawler przeszuka wszystkie strony na witrynie, zacznie następnie podążać za wewnętrznymi linkami, co prowadzi do znacznie wyższej liczby stron i niepotrzebnego index bloat.

- Ogólne strony treści o niskiej wartości, takie jak strony 'dziękuję' lub świadectwa, podstrony logowania, polityka prywatności czy prosty kontakt. Te byłyby uważane za treści niskiej jakości/ cienkie i nie powinny być indeksowane przez crawlerów wyszukiwarek.

W istocie, każda strona wymieniona przez wyszukiwarkę, która nie daje wartości użytkownikowi, jest index bloat i generuje zbędne problemy; stan takiej indeksacji może prowadzić do tego, że twoja marka traci ruchu oraz potencjalnych klientów. Niektórych nie można uniknąć, ale celem powinno być zminimalizowanie ich tak bardzo, jak to możliwe poprzez świadome zarządzanie indeksu oraz regularne działania optymalizacja.

Index bloat a cele biznesowe twojej witryny

Index bloat wprost wpływa na to, jak twoja witryna jest postrzegana przez google, wpływa na czas indeksacji nowej treści, szybkość wykonania robotów oraz na to, które stronach wyświetlać w wynikach wyszukiwania; w przypadku dużej liczby adresów url każda decyzja o dodaniu lub usunięciu sekcji może mieć znacząco biznesowe konsekwencje.

Dlatego warto, aby w strategia seo, content marketing i zarządzanie zawartości uwzględnić proces stałego monitorowanie index bloat, wykorzystać narzędzia online takie jak Labrika, google search console, google analytics oraz inne narzędzia do analiza logów serwera, aby szybkie wychwycić błędy i problemy zanim zaczną prowadzić do poważniejszych problemów widoczności.

Jak naprawić index bloat na swojej witrynie i skutecznie ograniczyć problemy z indeksacją

Masz naprawdę dwie opcje, czyli dwa podstawowe kroki strategiczne:

- Usuwasz niechciane strony, zbędnych podstron archiwalnych, case testowych oraz stron generowane przez system.

- Mówisz wyszukiwarkom, aby ich nie indeksowały, wykorzystując odpowiednie tagi meta, pliku robots, noindex oraz przekierowania 301.

Tak proste, jak to brzmi, może to zająć trochę czasu i zasoby serwera. Może również zająć trochę czasu, aby pozytywne wyniki pokazały się z Twojej pracy, zarówno w raportach google analytics, jak i w raportach pokrycia indeksu w google search console. Jednak bądź pewny, że z czasem się to opłaci. Aby ustalić strony, które należy usunąć, musisz przeanalizować wskaźnik indeksowania swojej witryny, sprawdź komendę site: w wyszukiwarce (upewniając się, aby wymienić ważne strony, które muszą być indeksowane). Musisz następnie porównać to krzyżowo ze stronami, które Google indeksuje oraz z tym, co zawiera mapa witryny. Nadwyżka to index bloat, którego chcesz się pozbyć i rozwiązać ten problemu.

Możesz zacząć od celowania w niskie owoce. To znaczy strony, które możesz łatwo zidentyfikować w swojej mapie witryny XML, które nie powinny tam być i które nie generują ruchu ani konwersji. Następnie usuń je z swojej mapy witryny i/lub usuń, jeśli nie służą już żadnemu celowi, wybierz wybrane sekcje do zachowania i zadbaj o poprawy wewnętrznych linków.

Możesz zidentyfikować inne obraźliwe strony na kilka sposobów, wykorzystując zarówno narzędzia automatyczne, jak i ręczne metody analizy:

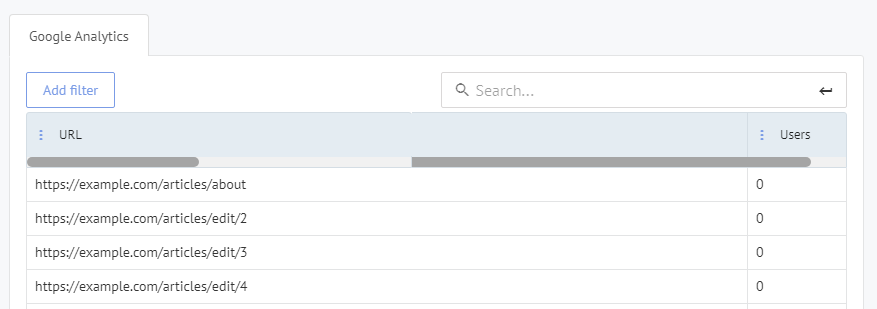

- Użyj usługi online, takiej jak Labrika, aby je zidentyfikować dla Ciebie jako część audyt seo i stałego monitorowanie; można też korzystać z innych narzędzia, ale nasze rozwiązanie ułatwia całość procesu. Możesz to zrobić za pośrednictwem naszego raportu 'dane zachowania użytkowników', w sekcji 'strony bez żadnego ruchu'.

- . To prawdopodobnie najłatwiejsza opcja, gdy chcesz szybkie wyniki bez dużych kosztów zasobów.

- Analizuj swoje pliki dziennika i znajdź strony, które użytkownicy odwiedzają, o których być może nie wiedziałeś, oraz inne strony o niskiej wartości; taka analiza danych z serwera pozwala też wykryć błędne przekierowania i inne problemy techniczne. Możesz znaleźć niektóre niespodzianki!

- Sprawdź w Google Search Console raport 'pokrycie indeksu', który wymienia strony, które Google indeksuje dla Twojej witryny, pokazuje błędy indeksowania, stan poszczególnych sekcji oraz pozwala zgłosić i prześlij mapę witryny.

Możesz również ograniczyć dostęp do treści i zapobiec indeksowaniu przez crawlerów internetowych

Podczas gdy nie możesz zapobiec crawlerom internetowym dostępu do strony, możesz im nakazać, aby jej nie indeksowali i w ten sposób kontrolować index bloat oraz wpływ na seo. Większość wyszukiwarek będzie przestrzegać tej dyrektywy, ale inne mogą nie, więc to nie jest metoda niezawodna, chociaż w praktyce google bardzo często respektuje poprawnie wdrożone tagi meta oraz dyrektywy dla robotów.

Jeśli masz treści, które są naprawdę poufne, będziesz potrzebować bardziej zaawansowanych funkcji bezpieczeństwa, aby zablokować crawlerów internetowych i ograniczyć ryzyko przypadkowego index bloat w tych sekcjach. Jedną z nich jest plik .htaccess, który może kontrolować, kto widzi co w poszczególnych folderach, a także jakie adresów url są w ogóle dostępne dla robotów. Jednak jest to złożony, techniczny proces, nie do wykonania przez początkujących i w przypadku dużych stron internetowych warto zaangażować specjalistów seo lub administratora serwera.

4 łatwe sposoby na uporządkowanie index bloat

Poniższe działania to praktyczne kroki, które można zastosować podczas każdej optymalizacja technicznej, aby index bloat nie rósł w niekontrolowany sposób i aby google lepiej rozumiało strukturę twojej witryny.

- Usuń duplikaty stron, niechciane strony, stare strony testowe i tak dalej, koncentrując się najpierw na tych, które nie generują ruchu, mają błędne przekierowania lub są wynikiem przestarzałej wersji kodu.

- Usuń strony o niskiej wartości z swojej mapy witryny XML i oznacz je tagiem meta noindex w sekcji HTML <head>. Można to zrobić w ten sposób:

<head> <meta name="robots" content="noindex"> </head>

- Możesz wprowadzić to ręcznie lub za pośrednictwem wtyczki, takiej jak Yoast na stronie Wordpress, co znacząco ułatwia zarządzanie dużą liczbę podstron i ograniczanie index bloat bez edycji każdej strony osobno.

- Ustaw dyrektywę disallow w swoim pliku robots.txt, aby wskazać, które foldery lub poszczególne strony nie crawlować. Ta treść nie będzie wtedy crawlowana ani indeksowana przez wyszukiwarki, co pozwala skierować crawl budget na kluczowe treści.

User-agent: googlebot Disallow: /testimonials/ Disallow: /checkout/ Disallow: /content-page1.htm/

- Ustaw dyrektywę noindex w swoim pliku robot.txt. Strony będą crawlowane, ale nie indeksowane przez wyszukiwarki; to ważne, gdy potrzebujesz dostępu dla robotów do analizy linków lub funkcji serwisu, ale nie chcesz generować dodatkowego index bloat w indeksie google.

Noindex: /content-page1.htm/

Takie proste, dobrze zaplanowane działania optymalizacja pozwalają ograniczyć liczbę zbędnych adresów url w indeksie, uporządkować strukturę kategorii i sekcji oraz poprawić performance witryny w wynikach wyszukiwania.

Do’s i don’ts podczas pracy nad index bloat

Wdrożenie technicznych zmian bez planu może tworzyć kolejne problemy, błędy indeksowania oraz nawet utratę ważnego ruchu, dlatego warto trzymać się kilku praktyki, które ułatwią zarządzanie indeksie i index bloat w dłuższej perspektywie.

- Nie pozwól, aby strony wyników wewnętrznego wyszukiwania (gdy użytkownik używa paska wyszukiwania na Twojej witrynie) były crawlowane przez wyszukiwarki. W przeciwnym razie wyszukiwacze mogą kliknąć link na stronie wyników wyszukiwania, ale zostać skierowani do jakiejś innej strony wyników wyszukiwania na Twojej witrynie i ten typ index bloat szybko się powiększa. To zapewniłoby złe doświadczenie użytkownika oraz obniżyło jakość całej domeny w oczach google.

- Jeśli usługi proxy generują URL dla Twojej witryny, nie pozwól, aby były crawlowane, ponieważ takie adresów url często prowadzą do duplikatów treści, błędów, a nawet do nieprawidłowe wersji stron i przez google mogą być błędnie interpretowane.

- Przeprowadź dokładny audyt SEO, albo przez specjalistę SEO, albo przez narzędzie online, takie jak my tutaj w Labrika; jest index bloat jednym z obszarów, które szczególnie analizujemy w kontekście crawl budget i optymalizacja techniczna. Nasz raport zachowania użytkowników pozwala zobaczyć strony, które nie mają ruchu i dlatego prawdopodobnie 'nadymają' Twoją witrynę.

Podczas wdrożenie takich działań upewnij się, że polityka prywatności, strona kontakt, informacje o firmie oraz kluczowe treści usług nie zostaną przypadkowo objęte noindex lub disallow; każdej zmiany w pliku robots czy mapie witryny powinna towarzyszyć analiza w google search console, aby wychwycić ewentualny błąd i uniknąć problemów z widoczności.

Jak monitorować index bloat przy użyciu danych i narzędzia

Skuteczne zarządzanie index bloat wymaga stałego monitorowanie danych technicznych oraz jakościowych. Dzięki temu można szybko reagować, kiedy stan indeksu, indeksach czy innych parametrów zaczyna wskazywać na nadmierną liczbę zaindeksowanych podstron.

Po pierwsze, korzystać z google search console, aby regularnie przeglądać raporty pokrycia, stan adresów url, błędów indeksowania i noindex. W tych raportach zobaczysz, które stronach zostały odrzucone, które zostały dodane do indeksu oraz gdzie index bloat może zacząć rosnąć, na przykład w wyniku błędne konfiguracji filtrów lub nowych sekcji sklepu.

Po drugie, google analytics pozwala ocenić, które strony mają ruchu, jak użytkowników zachowuje się na danej stronie oraz czy konkretne sekcje generują wartość biznesową. Strony bez sesji lub z bardzo niską jakością ruchu często są kandydatami do wyłączenia z indeksu, co pomaga skutecznie zmniejszyć index bloat i poprawić zarządzanie zasoby serwera.

Po trzecie, analiza logów serwera ułatwia ocenę, jak roboty googlebot i inne roboty faktycznie poruszają się po witrynie, ile czasu spędzają na poszczególnych ścieżkach i gdzie budżet crawl jest marnowany. Dzięki temu możesz zdecydować, które sekcje powinny zostać, a które można usunąć lub oznaczyć jako noindex, by index bloat nie rósł bez kontroli.

Rola struktury informacji w ograniczaniu index bloat

Index bloat często jest wynikiem braku spójnej struktury informacji, nadmiernej liczby kategorii, słabego linkowanie wewnętrznego oraz braku hierarchii w menu. Kiedy na jednej domeny powstaje wiele podobnych sekcji, artykuły są powielane, a tagi tworzone bez strategii, google może mieć trudność z oceną, które strony są najważniejsze i które należy wyświetlać wysoko w wynikach wyszukiwania.

Projektując struktury kategorii, użycie tagów oraz linki między stronami, pamiętaj, że każda nowa podstrona potencjalnie zwiększa index bloat. Dlatego warto planować content marketing, blog i podstrony ofert w taki sposób, aby treści były unikalnej, wartościowych dla użytkownika i dobrze osadzone w logice całej witryny, zamiast mnożyć kolejne, bardzo podobne strony.

W praktyce oznacza to między innymi:

- Ograniczanie liczby tagów i archiwów dat, które najczęściej tworzą mało wartościowe strony o podobnej treści.

- Porządkowanie kategorii tak, aby każda miała jasno określoną rolę i nie dublowała funkcji innych sekcji.

- Stosowanie przekierowania 301 dla nieaktualnych adresów url na lepsze odpowiedniki zamiast pozostawiania osieroconych stron, które zasilają index bloat.

- Dbanie o to, by każda ważna strona była wspierana przez sensowne linki wewnętrzne, co ułatwia robotom interpretację struktury i pomaga w optymalizacja crawl budget.

Index bloat w commerce i dużych sklepów online

W serwisach commerce, gdzie dziesiątki tysięcy produktów generują ogromną liczbę kombinacji filtrów, parametrów i wersji adresów url, index bloat może pojawić się bardzo szybko. Filtry typu kolor, rozmiar, cena czy producent, jeśli są dostępne z zewnątrz dla robotów, mogą tworzyć tysiące niemal identycznych stron, które nie wnoszą wartości, ale zużywają crawl budget.

Dlatego w takich projektach szczególnie ważne jest poprawne używanie plików robots.txt, tagów meta robots, a także atrybutu canonical, aby wskazać google wersję kanoniczną produktów i kategorii. Właściwe zarządzanie indeksów oraz indeksacją pozwala ograniczyć index bloat, poprawić performance witryny i skupić ruchu na stronach, które faktycznie generują sprzedaży.

Firmy, które mają wiele domen lub wersji językowych, powinny także zadbać o spójne praktyki zarządzania indeksie w każdej wersji serwisu, aby nie doprowadzić do sytuacji, w której te same treści pojawiają się wielokrotnie w różnych indeksach regionalnych google.

Współpraca z zespołem i specjalistami przy ograniczaniu nadmiernej indeksacji

W wielu sytuacjach najlepsze efektywne metody pracy nad nadmierną liczbą zaindeksowanych stron wymagają współpracy kilku zespołów: marketingu, IT, content marketing oraz działu odpowiedzialnego za sprzedaży i obsługę klientów. Każdy z tych działów ma inne dane, inną perspektywę na treści i stronach, dzięki czemu łatwiej znaleźć strony, które mają realną wartość oraz te, które powinny zostać wyłączone.

Marketing zna zapytania użytkowników i wie, które treści generują leady, IT kontroluje serwer, kodu oraz struktury, content marketing dba o unikalnej treści i artykuły, a dział sprzedaży widzi, jakie informacje pomagają domykać transakcje. Łącząc te informacje, można przygotować listę stron do utrzymania, listę stron do poprawy oraz listę, które warto usunąć lub skorzystać z noindex.

W przypadku większych firm warto, aby działania te wspierał doświadczony audyt seo oraz specjalistów, którzy widzieli już wiele case podobnych sytuacji i potrafią szybko wskazać najczęstsze problemy, błędne konfiguracje i praktyki, które prowadzić mogą do problemu nadmiernej liczby podstron w wynikach wyszukiwania.

Jak nasze narzędzia pomagają firmom uporządkować nadmierną indeksację

Labrika została zaprojektowana tak, aby pomóc właścicielom stron internetowych, sklepów online i blog w identyfikowaniu stron, które nie przynoszą wartości, a jedynie obciążają witryny, zasoby oraz roboty wyszukiwarek. Dzięki zintegrowanej analiza danych, raportom o zachowaniach użytkowników i wglądowi w technicznych elementów serwisu narzędzie ułatwia szybkie wskazanie adresów url, które mogą zostać usunięte lub ograniczone.

Nasz system analizuje m.in. ruchu, czas spędzony na stronach, źródła wejść, struktury nawigacji i menu, a także dane z narzędzi takich jak google search console czy google analytics. Na tej podstawie generowane są raporty, które pokazują, gdzie znajdują się zbędnych podstron, jakie sekcje nie mają żadnego ruchu oraz które elementów treści mogą wymagać usprawnienia.

W praktyce otrzymujesz listę konkretnych kroków, jakie warto wykonać przed wdrożeniem większych zmian na stronie, aby ograniczyć ryzyko problemów technicznych oraz błędów. Można dzięki temu lepiej zaplanować działania, wykorzystać istnieje już dane i wdrożyć poprawy w taki sposób, aby nie utracić wartościowych podstron ani pozycji w wynikach wyszukiwania.

Przykładowe działania, które możesz przeprowadzić z wykorzystaniem naszego rozwiązania

- Wyszukanie stron bez ruchu lub z minimalnym ruchem i podjęcie decyzji, czy powinny zostać, zmienione czy usunięte; w razie potrzeby można przygotować przekierowania, aby użytkownicy trafiali na lepsze treści.

- Analiza stronach z wysokim ruchem, ale niską konwersją, aby sprawdzić, czy ich treści, struktury lub linkowanie wewnętrznego wymagają modyfikacji, co często pozwala znacząco zwiększyć efektywność całego procesu sprzedaży online.

- Przegląd technicznych statusów, błędów, nieprawidłowe odpowiedzi serwera oraz roboty napotykające problemy podczas odwiedzania strony, co ułatwia zarządzanie performance oraz poprawę wydajności.

- Weryfikacja, czy plik robots.txt, mapy, tagi meta oraz inne elementów technicznych zostały poprawnie skonfigurowane i czy nie blokują przypadkiem treści, które powinny być dostępne w wynikach wyszukiwania.

Podsumowanie: znajdowanie i kontrola nadmiernej liczby zaindeksowanych stron

Głównym celem każdej wyszukiwarki jest bycie najlepszym w dostarczaniu najlepszych wyników jakości dla swoich użytkowników. Aby to osiągnąć, wdrażają znaczne zasoby, aby identyfikować i odrzucać strony (lub całe witryny), które nie spełniają ich kryteriów, a nadmierna liczba mało wartościowych podstron może obniżać ocenę całej domeny.

Jest to również proces, który nadal jest ulepszany i udoskonalany. To oznacza, że my, jako profesjonaliści oraz webmasterzy, musimy robić nasze najlepsze, aby wyprzedzić te problemy, reagować na błędów raportowane w narzędziach, regularnie przeglądać dane oraz monitorować stan poszczególnych sekcji serwisu.

Ten typ problemu technicznego powinien stać się ważną częścią przeglądu jakości każdej witryny. Upewnij się, że roboty widzą tylko najlepsze z Twojej treści, a użytkowników otrzymują spójne, aktualne informacje, których szukają, bez generowania chaosu w strukturze stron.

Wykonywanie poprawek, które opisaliśmy powyżej, jest kluczowym krokiem w poprawie widoczności, lepszym zarządzanie ruchem oraz efektywnym wykorzystaniu zasobów serwera. Dzięki temu Twoja witryny może rozwijać się stabilnie, przyciągać więcej klientów i budować długoterminową przewagę konkurencyjną.

DARMOWA WERSJA PRÓBNA

Jeśli chcesz sprawdzić, w jakim stanie znajdują się Twojej stronach i ile zbędnych podstron może obciążać działania marketingowe, warto skorzystać z darmowego dostępu do naszego systemu. Wersja testowa zawiera kluczowe funkcji potrzebne do wstępnej diagnozy, pokazuje stan ważnych podstron oraz pozwala zobaczyć, które elementów wymagają szybkiej poprawy.

Rozpocznij bezpłatny okres próbny teraz

Aby rozpocząć, załóż konta, prześlij adres swojej witryny, dodaj mapy i plik robots, a następnie uruchom pierwszą analiza. W ciągu kilku dni otrzymasz zestaw raportów, które pomogą Ci zrozumieć, gdzie pojawiają się potencjalne problemy, jak je rozwiązać i jakie kroki podjąć, aby Twoja strona jest lepiej przygotowana do rywalizacji w wynikach wyszukiwania.

Nasz zespół specjalistów może także pomóc w interpretacji danych, odpowiedzieć na pytania oraz zaproponować praktyczne działania dopasowane do sytuacji konkretnej domeny, branży i wielkości serwisu. Dzięki temu nawet osoby bez zaawansowanej wiedzy technicznej mogą skutecznie korzystać z narzędzia i wdrażać zalecenia.

Funkcje

Platforma Labrika zawiera szereg funkcji wspierających zarządzanie stron internetowych, w tym:

- kompleksowy audyt techniczny witryny, obejmujący analizę wielu typów problemów oraz błędów,

- monitorowanie widoczności w wyszukiwarce oraz wybrane słowa kluczowe,

- ocenę jakości treści i propozycje ich poprawy, aby lepiej odpowiadały na zapytania użytkowników,

- analizę struktury serwisu, linków wewnętrznych, parametrów adresów oraz elementów nawigacyjnych,

- raporty dotyczące stron, które nie generują ruchu i mogą zostać uporządkowane, aby zwiększyć ogólną wartości całej witryny.

O nas

Labrika to zespół specjalistów z wieloletnim doświadczeniem w pracy nad stronach klientów z wielu branż, od małych firm usług po duże sklepy online. Łączymy wiedzy techniczną, biznesową oraz praktyczne doświadczenia, aby dostarczać narzędzia i usługi, które realnie pomagają poprawić wyniki oraz wydajności działań marketingowych.

- O firmie – znajdziesz tu informacje o naszej historii, wartościach i podejściu do pracy z klientami.

- Ceny – sekcja zawiera przejrzyste dane o dostępnych planach, tak aby można było łatwo dobrać rozwiązanie do potrzeb Twojej organizacji, bez zbędnych kosztów.

Zaktualizowano 31 grudnia 2025 r.